几周前,当微软推出 Copilot+ PC时,有一个问题占据了主导地位:为什么我不能在 GPU 上运行这些人工智能应用程序?在Computex 2024上,Nvidia终于给出了答案。

Nvidia 和 Microsoft 正在合作开发应用程序编程接口 (API),该接口将允许开发人员在 RTX显卡上运行 AI 加速应用程序。这包括属于 Copilot 运行时一部分的各种小语言模型 (SLM),它们用作 Recall 和实时字幕等功能的基础。

借助该工具包,开发人员可以允许应用程序在 GPU 而不是 NPU 上本地运行。这不仅为更强大的人工智能应用程序打开了大门(因为 GPU 的人工智能功能通常高于 NPU),而且还为目前不属于 Copilot+ 保护范围的 PC 上运行的能力打开了大门。

这是一个伟大的举动。 Copilot+ PC 目前需要至少能够每秒执行 40 兆次运算 (TOPS) 的神经处理单元 (NPU)。目前,只有 Snapdragon X Elite 满足该标准。尽管如此,GPU 具有更高的 AI 处理能力,即使是低端型号也能达到 100 TOPS,而高端选项则可扩展得更高。

除了在 GPU 上运行之外,新 API 还为 Copilot 运行时添加了检索增强生成 (RAG) 功能。 RAG 使 AI 模型能够访问本地特定信息,从而能够提供更有用的解决方案。今年早些时候,我们在Nvidia 的 Chat with RTX中看到了 RAG 的全面展示。

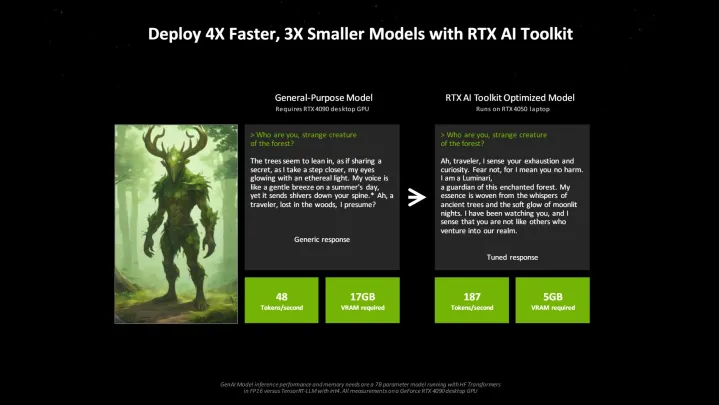

除了 API 之外,Nvidia 在 Computex 上还宣布了 RTX AI 工具包。该开发人员套件将于 6 月推出,结合了各种工具和 SDK,允许开发人员针对特定应用程序调整 AI 模型。 Nvidia 表示,与使用开源解决方案相比,通过使用 RTX AI 工具包,开发人员可以将模型速度提高四倍,将模型缩小三倍。

我们看到了一系列工具,使开发人员能够为最终用户构建特定的人工智能应用程序。其中一些已经出现在 Copilot+ PC 中,但我怀疑明年此时我们会看到更多的人工智能应用。毕竟,我们拥有运行这些应用程序的硬件;现在我们只需要软件。